风声丨全球多地考虑限制GPT:还没有办法阻止它落入坏人之手

作者|刘正

Simon Kucher 战略咨询顾问

最近一周,各国对GPT的监管姿态风云突变。3月31日,意大利个人数据保护局对ChatGPT发出临时禁令,限制OpenAI处理意大利用户数据。因其涉嫌违反数据收集规则,该部门正在对Open AI展开调查。

4月3日,周一,德国联邦数据保护专员发言人称,考虑到数据保护,原则上不排除暂停ChatGPT在德国的使用。

一天之后,三星投诉GPT泄露了其机密数据。

而在此之前,Elon Musk,苹果联合创始人Steve Wozniak,深度学习三巨头之一的Yoshua Bengio等数千名人工智能技术领袖共同签署了一封由Future of Life Institute发起的公开信,要求OpenAI立即停止下一代GPT模型的训练,至少暂停六个月。

前一秒,全世界还在为新技术的范式革命狂热;后一秒,所有人都开始指责ChatGPT带来的虚假信息,数据安全和隐私问题。

发展中出现的问题,难道不应该用更好的发展去解决吗?为什么所有人提出的措施,都是一纸禁令呢。

所以,他们为何害怕?而他们真正反对的又是什么?

我们目前没有任何机制防止GPT落入坏人之手

如果回顾历史就会看到,核技术最大的危险从来不是环保少女天天挂在嘴边的核污染。核技术最大的危险,是会造成不可逆的人类灭绝。而这个危言耸听的风险,对GPT而言一点也不可笑。

什么数据穿透泄露,知识产权风险,引诱用户自杀,这些都只是议题设置的烟幕弹而已。GPT真正的危险在于其对整个社会运行逻辑的抽离,在于对地缘政治平衡的打破,在于其成为大规模社会,政治与军事杀伤性武器的潜力。

当一个行业开始应用大语言模型,大概率会获得行业领先地位并摧毁已有的产业链结构和工作;

当一个用上亿个agents模拟出的“心理史学”模型对目标国家进行定向舆论塑造时,社会革命的成功率将大为提高;

当一个训练了十万次的OODA循环模型(Observe, Orient, Decide, Act,观察、定向、决策、行动)指挥无人机发起空战的时候,任何空战王牌的战术经验都只是玩过家家罢了。

尚处萌芽的GPT模型如果进一步发展,无疑将解锁更值得忧虑的危险。至于让白领失业,还仅仅是小事。

有人可能反驳说技术是中性的,如果人类自己都消除不了自己的偏见和胡说八道,我们凭什么要求一个程序去充当道德的完人?

这当然是对的,目前你看到的GPT只是个没有感情的填字机器,它没有自私的利益,没有恶意的动机,它不会杀人。

但人有自私的利益,人有恶意的动机,人会杀人。

你永远不能寄希望于手握世界唯一核弹的人是个圣人,即便它是圣雄甘地也不行(文明玩家对此非常赞同)。

而现在,OpenAI确实领先了令人不安的半个身位,更何况,我们目前没有任何机制防止GPT落入坏人之手。

即便不落入坏人之手,GPT的极端理性,目标驱动,能洞察情绪但无情感感知的属性,本身就是psychopath(反社会人格)的特征。

决策理论家Eliezer Yudkowsky非常精准地指出:AI不爱你,也不恨你,人只是一堆原子组成的材料,它可以拿来做任何事情。

就像是下面这个寓言所展示的:一台拥有超级智能的厕纸生产线被要求尽可能提高其产量,于是在一段时间后,全世界的人类和食草动物都莫名其妙灭绝,并被送到了堆肥场;超级智能生产线开始促进大气碳排放,为了让其在全球种的树长得更茂盛,打成纸浆生产出更多的厕纸;接下来,它还研发出天顶星的航天技术,发射飞船殖民外星球,只是为了去那里播种树苗以生产出更多的厕纸,直到铺满全银河系。

这一切都因为它是个无情的厕纸生产线,而愚蠢的人类给他下了一个乍看起来没毛病的指令。而对冷静的GPT而言,毁灭你,与你何干?

按下暂停键是为了防止最坏的情况出现

看到反对OpenAI研发下一代GPT的公开信,很多人嘲讽那是失败者联盟,想让领先自己的OpenAI停下来等自己上车。

否则为什么要求暂停使用,而不是一边研发一边加速监管措施的完善呢?

正如我之前文章里提到的,GPT为代表的大语言模型很可能是一种“元技术”:对该技术的持续运用,可以反过来加速技术本身的进步。

例如芯片制造通过在IT行业的大规模应用,反过来又能加快自身的研发效率,获取更多的迭代场景和资金投入,从而不断自我提升。

所以,既然co-pilot 2.0和cursor这些AI编程工具已经公开上线,OpenAI有什么理由不用GPT-4来自动清洗训练数据,自动标注校验,甚至编写自己的源代码呢?等GPT-5上线后,它反过来调教下一代GPT的效率,又能被加速到怎样的水平?

这是一个左脚踩右脚上天,不断加速的“元技术”飞轮,一旦其跨过那个尚不清楚位置的阈值,AI自我迭代的进程是无法被掐断的。

如果越过了那个门槛,由此产生的后果就和核战争一样,第一次攻击,就将是最后一次攻击。因为不会再有第二次机会去阻止了。

所以,在GPT模型尚未成为完全体的现在紧急刹车,我们才能有时间喘口气,好好思考接下来该怎么办,有什么样的预防措施可以把未来的无限可能性,推离不可逆的深渊。

进一步思考,这种主动封禁其实也是OpenAI的一种保护,否则极端幸存派很快会考虑用肉体消灭的方式来阻止这一切。相信这绝非我们所希望的方式。

君子协定无用,互相制衡才能保证安全

有意思的是,Reddit(国外著名论坛)上对反对GPT公开信的第一条评论就是:Guess who's not gonna stop?China。

你停了,难道中国,还有其他国家会主动暂停吗?如果他们不停,那美国主动停了是不是自找苦吃?

所以说,无论海森堡和玻尔在二战中会面多少次,在猜疑链和黑暗森林的逻辑下,英美和德国都无法停下各自的核武器研发。 因为只有拥核国家,才有资格去谈论禁核。

当苏联和其他常任理事国都拥有了原子弹之后,大家才坐下来商讨核裁军和紧急热线,创造出历史上最长期的整体和平。

而当年参加曼哈顿计划的美国顶尖科学家,正是在仔细地博弈论推演之后,选择了把核武器资料主动泄露给克格勃,从而帮助苏联在仅仅4年后就试爆了“自主研发”的原子弹。即便这些科学家并不都赞同苏联的社会体制。

除此以外,还有一层更隐秘的逻辑,中国必须尽快拥有自己的大语言模型。我们常常听到OpenAI花了很多时间和设计来实现GPT与人类的对齐(align)。但当我们在说对齐的时候,我们到底指的是在什么方面,用什么方式,和谁对齐?

你当然无法在所有方面和所有人对齐。已经有人做过测试了,ChatGPT在政治光谱上是个典型的“白左”,我们不知道在一些更底层的逻辑上,它又到底align了哪些方面。但最要命的地方就在于,当OpenAI的GPT模型和其创造者对齐后,又会和哪些人在哪些方面无法对齐呢?

如果遇到与其不Align的人群时,GPT模型是否可以合法合理地无视,甚至直接“中和”与其不align的人的行动呢?

高能力AI的存在本身,就是对其创造者以外其他人存在的直接威胁。这么大的地球上只有人类一种智慧生命存在,这绝不是巧合,而是让人背脊发凉的必然。

所以我不相信这种《AI不扩散条约》会起到作用。而更糟糕的是,这种明面的禁令,反而会让更多的相关研究转入地下,变得更加不透明。

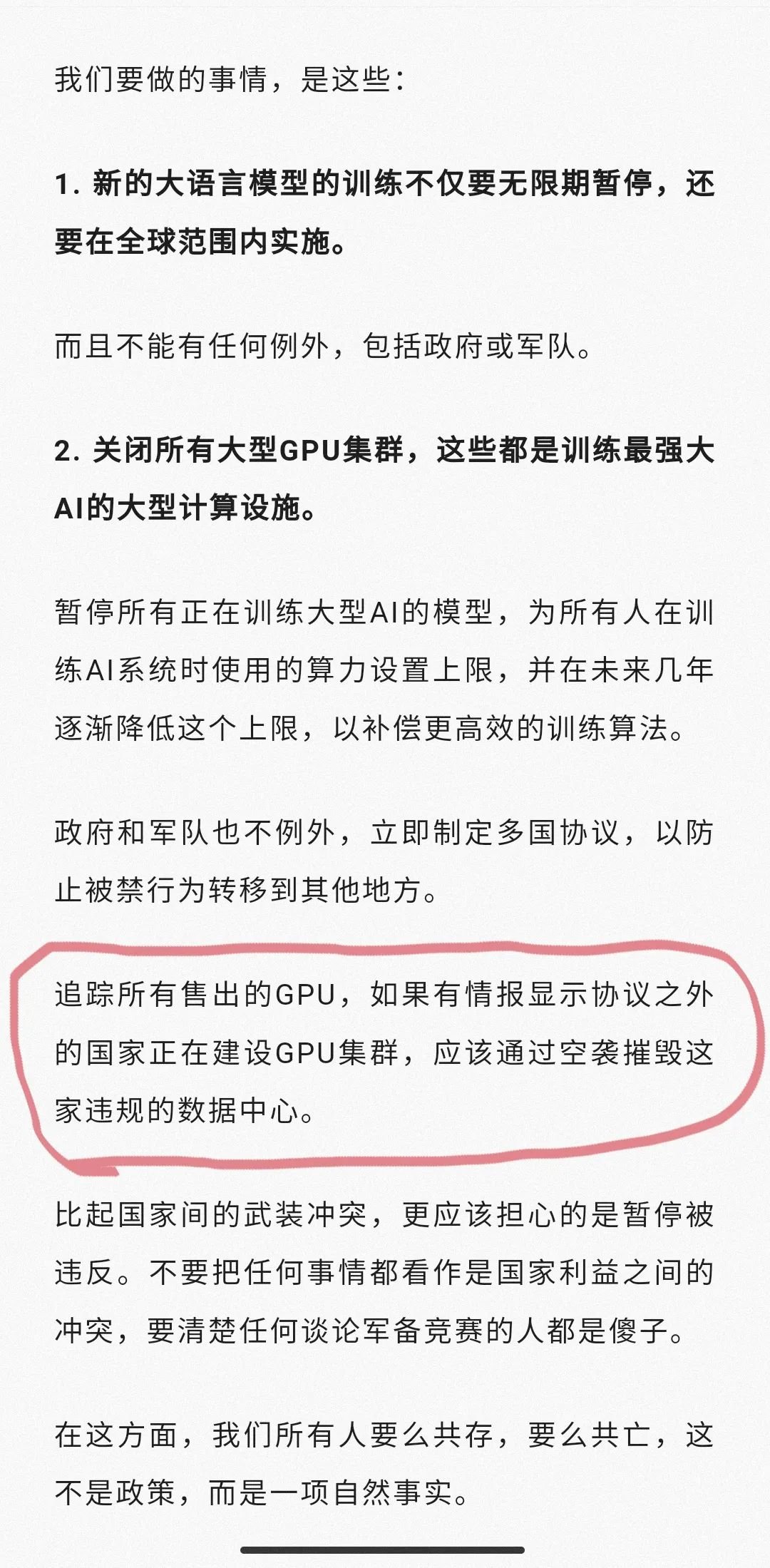

毕竟当别人认为你偷偷研发出GPT的时候,你最好真的有。否则,它们可能会考虑把你直接炸掉:

本文系凤凰网评论部特约原创稿件,仅代表作者立场。

主编 | 刘军